Оценивать цифровые релизы «на глаз» уже не работает. Одному кажется, что фича «зашла», другому — что зря потратили месяц. Чтобы не спорить на эмоциях, нужны понятные метрики и прозрачный процесс, который одинаково читает и продукт, и маркетинг, и разработка.

Ниже разберём, какие метрики действительно важны для оценки релиза, какие подходы к измерению бывают, чем они отличаются и как всё это собрать в рабочую систему, а не в очередную «доску с цифрами для отчёта».

—

Зачем вообще измерять цифровые релизы

Если упростить до одного вопроса, нас всегда волнует: «Релиз сделал продукт лучше или мы просто добавили шум?». Метрики — это способ ответить без догадок.

Оценка эффективности цифровых продуктов метрики обычно крутятся вокруг трёх осей: ценность для пользователя, влияние на бизнес и качество технической реализации. Баланс между этими осями и определяет, успешен релиз или нет.

Ключевые метрики для цифровых релизов помогают:

— отфильтровать «косметические» улучшения от реального прироста ценности;

— быстрее замечать неудачные решения и сворачивать их;

— аргументировать приоритизацию перед стейкхолдерами без лишних дискуссий.

—

Ключевые метрики: что действительно важно

Продуктовые метрики: поведение и ценность для пользователя

Начнём с ядра. Метрики продуктовой аналитики для запуска цифровых сервисов отвечают на вопрос: «Что изменилось в поведении пользователей после релиза?». Здесь важно не количество кликов само по себе, а то, приблизили ли мы пользователя к его цели.

Базовый набор:

1. Конверсия по воронке (от входа до целевого действия).

2. Retention / удержание (возвращается ли пользователь через N дней).

3. Частота использования ключевых функций.

4. Время до достижения ценности (time to value).

К примеру, вы выкатываете новый онбординг. Конверсия из регистрации в первый ключевой сценарий растёт — релиз сработал. Если растёт только число открытий экрана, но люди вываливаются дальше — это «псевдоуспех».

—

Бизнес‑метрики: деньги и операционная эффективность

kpi и метрики цифровых продуктов для бизнеса связаны с выручкой, маржой, cost-to-serve и другими «денежными» показателями. Они важны, чтобы понять, не делаем ли мы «красивые, но убыточные» решения.

Частые метрики:

— ARPU / ARPPU (средний доход на пользователя / платящего пользователя);

— LTV (lifetime value);

— CAC (стоимость привлечения клиента) и payback period;

— влияние на апсейл/кросс-сейл;

— отказ от услуги / churn.

Критичный момент: бизнес-метрики меняются медленнее. Поэтому их нельзя использовать как единственный критерий конкретного релиза, но важно проверять, что продуктовые улучшения в итоге бьют именно сюда, а не только в «красивые дашборды».

—

Технические метрики: стабильность и производительность

Даже лучший сценарий провалится, если сервис лагает или падает. Для оценки технической стороны релиза смотрят на:

— латентность ключевых API и страниц;

— частоту ошибок (error rate, HTTP 5xx/4xx, JS‑ошибки);

— uptime и SLO/SLA;

— потребление ресурсов (CPU, память, запросы к БД).

Это особенно критично для high‑load систем: релиз может увеличивать конверсию, но, например, удвоить нагрузку на базу. Тогда придётся думать не только о feature‑ценности, но и о стоимости владения.

—

Пользовательские метрики: удовлетворённость и «ощущения»

Цифры в логах — не всё. Бывают релизы, которые немного ухудшают конверсию, но заметно повышают доверие и NPS. Если ваша цель — долгосрочные отношения с пользователем, такие эффекты тоже стоит мерить.

Сюда относятся:

— NPS, CSAT, CES;

— количество жалоб/тикетов по теме релиза;

— качественная обратная связь из интервью и отзывов.

Тонкость в том, что такие метрики легко «испортить» неправильными вопросами и формулировками, поэтому важно держать единый стандарт сбора фидбека.

—

Необходимые инструменты: чем всё это мерить

Чтобы вся эта система не осталась на бумаге, нужны инструменты, которые покрывают три слоя: продуктовая аналитика, эксперименты и техмониторинг.

Длинный, но практичный сетап может выглядеть так:

1. Система продуктовой аналитики

Amplitude, Mixpanel, Yandex Metrica, GA4 и им подобные. Они позволяют строить воронки, пути пользователей, когортный анализ, считать retention и сегментировать по аудиторным признакам. Это основа, без которой оценка любого цифрового релиза превращается в угадайку.

2. Платформа для A/B‑тестов и feature flags

Это может быть как отдельный сервис (Optimizely, Split.io, GrowthBook), так и встроенное решение в вашем продукте. Важен не бренд, а то, чтобы:

— можно было делить трафик на группы;

— учитывать статистическую значимость;

— по флагу быстро откатывать релиз.

3. Система логирования и мониторинга

Prometheus + Grafana, ELK‑стек, Sentry, New Relic — любая связка, которая даёт вам:

— realtime‑monitors по ключевым ошибкам и латентности;

— алерты для on‑call команды;

— возможность разбирать инциденты постфактум.

4. Инструменты сбора обратной связи

Встроенные NPS‑виджеты, опросы в продукте, Helpdesk‑системы (Zendesk, JIRA Service Management), простые формы на сайте — всё, что помогает собрать живой голос пользователя, а не только анонимную статистику.

5. Хранилище данных и BI

DWH (Snowflake, BigQuery, ClickHouse и т.п.) и BI‑слой (Looker, Power BI, Metabase) для склейки разрозненных источников. Без этого легко получить ситуацию, когда «каждый отчёт рисует свою правду».

—

Поэтапный процесс: как измерить успешность цифрового релиза продукта

Набор инструментов сам по себе ничего не решает. Нужен понятный процесс, который команда повторяет от релиза к релизу.

Шаги, которые стоит закрепить в практике

1. Определяем цель релиза в терминах метрик

Не «сделать удобнее корзину», а «увеличить конверсию из добавления в корзину в оплату на 5%» или «сократить количество брошенных корзин на 10%». Конкретная цель = понятное измерение.

2. Выбираем основной и вспомогательные показатели

Один North Star (например, доля пользователей, дошедших до активации) и 2–3 вспомогательных метрики для диагностики (время сценария, число кликов, ошибки). Так проще интерпретировать результат и не утонуть в деталях.

3. Определяем, где и как будем считать цифры

Сразу решаем: какое событие в аналитике считается «успехом», какие свойства ему нужны, какие сегменты пользователей мы различаем. Чем ближе определение к коду и трекингу, тем меньше шансов потом обнаружить, что «мы всё измеряли не то».

4. Выбираем формат запуска: A/B‑тест, частичный rollout или полный релиз

— A/B‑тест — если есть достаточный трафик и нужен строгий контроль.

— Частичный rollout (например, 10–50% аудитории) — если хотим быстро собрать сигналы по рисковому изменению.

— Полный релиз — когда риск мал или изменения чисто технические (но даже тогда лучше иметь метрики для мониторинга регрессий).

5. Фиксируем период измерения и критерии успеха

Прописываем заранее: сколько времени собираем данные, какой минимум трафика нужен, какое изменение считаем значимым. Иначе всегда найдётся соблазн «подобрать удобный период».

6. Проводим релиз и наблюдаем в реалтайме

В первые часы смотрим на технические показатели (ошибки, латентность), в следующие дни — на продуктовые и бизнес‑метрики. Важно иметь заранее настроенные дашборды, а не строить отчёт по мере паники.

7. Подводим итоги и фиксируем знания

Сравниваем результат с гипотезой: что улучшилось, что ухудшилось, какие сегменты отреагировали по‑разному. Делаем короткий post‑mortem (даже если релиз успешен) и кладём выводы в общее знание компании.

—

Разные подходы к измерению и их сравнение

Подход 1: «Vanity‑метрики и отчёты для отчётов»

Знакомый сценарий: смотрим на количество установок, просмотров страниц, лайков и скачиваний, не связывая это с реальной ценностью. На дашборде всё красиво, но в бизнес‑результате — тишина.

Плюсы:

— легко собрать;

— не требует глубокой аналитической зрелости.

Минусы:

— плохо работает для принятия решений;

— легко манипулируется;

— не показывает, почему так произошло и что делать дальше.

Такой подход годится только как начальный уровень, когда продукта ещё почти нет, а вы просто проверяете базовый интерес.

—

Подход 2: Outcome‑ориентированный (поведение и бизнес‑эффект)

Здесь фокус смещён на то, какую реальную проблему мы решаем. Релиз оценивают по влиянию на end‑to‑end сценарий и kpi и метрики цифровых продуктов для бизнеса: завершённые заказы, активные подписки, retention, выручка на пользователя.

Плюсы:

— жёстко связывает релиз с реальной ценностью;

— помогает приоритизировать roadmap по вкладу, а не по «громкости» фичи;

— стимулирует думать гипотезами, а не тасками.

Минусы:

— требует зрелой аналитики и общий словарь метрик;

— результат часто виден не сразу (особенно для LTV, churn и т.п.);

— сложнее объяснить людям, привыкшим к простым vanity‑цифрам.

Для большинства цифровых продуктов этот подход — оптимальный целевой ориентир: именно он даёт возможность отвечать на вопрос «зачем мы это сделали» в деньгах и пользовательской ценности.

—

Подход 3: Экспериментально‑драйвовый (A/B‑тесты повсюду)

Здесь каждый более‑менее значимый релиз проходит через эксперимент: делим трафик, считаем статистическую значимость, принимаем решение по результатам.

Плюсы:

— минимизирует риск выката заведомо вредных изменений;

— позволяет находить «тонкие» эффекты, которые не видны глазом;

— создаёт культуру проверки гипотез, а не веры в мнения.

Минусы:

— требует достаточного трафика и дисциплины;

— легко скатиться в локальную оптимизацию (подкручиваем только то, что легко A/B‑тестить, игнорируя долгосрочные инициативы);

— сложен для B2B и нишевых продуктов с малым количеством событий.

Хорошая практика — сочетать этот подход с outcome‑ориентацией: эксперименты тестируют гипотезы, но меряют они не только клики, а те же ключевые метрики для цифровых релизов, связанные с бизнес‑результатом.

—

Подход 4: «Качественный упор» — интервью, UX‑исследования, фидбек

Иногда релиз нельзя корректно измерить только цифрами: новая навигация, изменение tone of voice, редизайн. Тогда основная ставка делается на качественные методы: юзабилити‑тесты, глубинные интервью, дневниковые исследования.

Плюсы:

— раскрывает контекст и мотивы поведения;

— помогает находить инсайты, которые не видно в логах;

— особенно полезен до релиза, на этапе прототипов.

Минусы:

— выборка обычно маленькая;

— сложно масштабировать и сравнивать во времени;

— легко получить «шумные» выводы без хорошего модератора.

На практике качественные и количественные подходы нужно сплетать: качественные методы помогают придумать сильные гипотезы, а количественные — проверить, сработали ли они «в бою».

—

Как подружить подходы между собой

Рабочая стратегия часто выглядит так:

— На уровне стратегии продукта — outcome‑ориентированный подход (бизнес и продуктовые эффекты).

— На уровне конкретных фич и UX‑изменений — A/B‑тесты и событийная аналитика.

— На уровне поиска идей и проблем — интервью, опросы и исследования.

— На уровне качества исполнения — технические метрики и мониторинг.

Тогда оценка эффективности цифровых продуктов метрики не разъезжаются между командами: каждый видит свою часть, но все играют в одну и ту же систему координат.

—

Устранение неполадок: когда с метриками что‑то пошло не так

Даже при аккуратной настройке периодически возникает ощущение: «цифрам верить нельзя». Разберём типовые проблемы и как их чинить.

Проблема 1: Метрики скачут, но продукт не менялся

Частые причины:

— сломалась интеграция трекинга (двойная отправка событий, потеря параметров);

— изменились источники трафика или состав аудитории;

— в аналитике «почистили» события или фильтры.

Что делать:

— иметь минимальный набор контрольных метрик (например, общее число сессий, ключевых событий) и автоматические алерты на аномалии;

— versioning схемы событий и прозрачный changelog любой правки в трекинге;

— регулярные sanity‑проверки: сравнение логов бэкенда и событий аналитики.

—

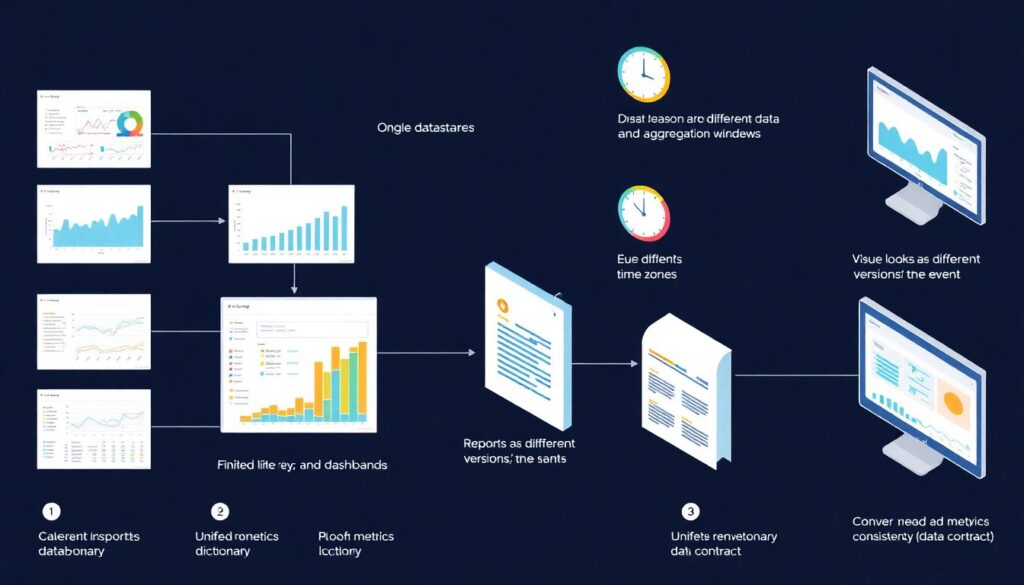

Проблема 2: В разных отчётах разные цифры за один и тот же период

Классика, особенно когда источник данных один, а отчётов много.

Основные причины:

— фильтры и сегменты настроены по‑разному;

— разный timezone или окно агрегации;

— отчёты смотрят на разные версии события.

Как лечить:

— описать единый «словарь метрик» (data contract): как именно считаем конверсию, retention, MAU и т.д.;

— зафиксировать часовой пояс и период агрегации по умолчанию;

— ограничить число «самодельных» отчётов без ревью аналитика.

—

Проблема 3: Релиз «по ощущениям» успешен, а по цифрам — нет

Такое случается, когда релиз даёт результат в другой плоскости, чем та, где вы меряете. Например, вы улучшили скорость загрузки страниц, а смотрите только на конверсию в покупку — эффект может быть размазан и неочевиден.

Подход к расследованию:

1. Проверить, что вы вообще меряете правильный слой (скорость, ошибки, локальные конверсии).

2. Проверить сегменты: возможно, улучшение заметно только у части аудитории (мобильные пользователи, медленный интернет, новый регион).

3. Пересмотреть гипотезу: возможно, релиз решает не ту проблему, на которую вы рассчитывали, но даёт другой полезный эффект — его стоит явно зафиксировать.

—

Проблема 4: Цифры есть, решений всё равно не принимаем

Иногда компании выстраивают впечатляющую аналитику, но решения по‑прежнему принимаются по принципу «кто громче». Значит, проблема не в инструментах, а в процессе.

Как сдвинуть ситуацию:

— договориться, что любой значимый релиз описывается как гипотеза с измеримым результатом;

— ввести ритуал разборов релизов (release review), где решения об эволюции фич обсуждаются на языке метрик;

— показывать метрики не только сверху вниз (от аналитиков к менеджерам), но и в команду разработки, чтобы все понимали, зачем и к чему они пишут код.

—

Итог: что оставить в голове

Оценка цифрового релиза — это не один «волшебный KPI», а связка:

— продуктовые метрики (поведение и ценность);

— бизнес‑показатели (деньги и эффективность);

— техметрики (стабильность и производительность);

— пользовательские сигналы (удовлетворённость и фидбек).

Метрики продуктовой аналитики для запуска цифровых сервисов превращаются в реальный инструмент только тогда, когда:

1. Цели релиза формулируются заранее и в цифрах.

2. Под них выбираются конкретные показатели и инструменты.

3. Команда сравнивает несколько подходов к измерению (vanity, outcome‑ориентированный, A/B‑тесты, качественные методы) и осознанно комбинирует их.

4. Любая аномалия в данных воспринимается как повод улучшить систему измерения, а не отменить цифры в пользу «интуиции».

Тогда вопрос «как измерить успешность цифрового релиза продукта» перестаёт быть философской задачей и становится частью обычной рутины: выкатили — посмотрели — сделали выводы — поехали дальше.